before devops

IT ändert sich. Immer! Und wie es scheint, immer schneller. Die Veränderung nennt man #devops. #devops ist ein Phänomen. Ich versuche, mich gemeinsam mit ein paar jungen IT-Freunden in einer Artikelreihe diesem Phänomen zu widmen. In diese Artikelreihe bin ich mit einem „Computer Vintage“-Artikel gestartet, der wunderschöne zeitgenössische Fundstücke enthält. Jetzt setze ich die Reihe mit einer „Kurzen Geschichte der IT“ fort. Dieser beschreibt die Zeit vor #devops.

#devops ist ein buzzword

Es umfasst so vieles: extreme programming, agile, cloud, 7 x 24 x 365. Ohne #devops gäbe es kein Internet, so wie wir es schätzen. Was steckt hinter dem buzzword? Ich persönlich habe den Einstieg in #devops mit dem Paradigmenwechsel von Mainframes zur lamp-Welt verbunden.

Bis dahin hatten wir zwei Welten, die der weißen und der blauen bzw. grauen Mäntel.

Die Weißen waren die Programmierer, die anderen die Operateure, später sysops genannt. Die Programmier schrieben die Funktionen, die Operateure haben dafür gesorgt, dass sie Maschinen liefen. Beides war ziemlich aufwändig.

Ich wollte immer einen weißen Mantel haben!

Mit der kurzen Geschichte der IT starte ich in die devops-Artikel-Serie, den Titel habe ich entlehnt bei Yuval Noah Harari; er hat mich mit seiner „kurzen Geschichte der Menschheit“ inspiriert. Ich versuche hier zu beschreiben, wie ich in die Welt der industriellen Informatik eingetaucht bin und welche eine gigantische Entwicklung ich erlebt habe. Hier kommt meine ganz persönliche Sicht auf die Welt der IT der 70iger Jahre, aus typischer deutscher (bayerischer) Sicht, so wie wir sie in München erlebt haben.

Mein IT-Leben begann 1969

Ich hatte mein Abitur am Jakob-Fugger-Gymnasium in Augsburg geschafft. Die Einberufung als Wehrpflichtiger bedrohte mich – und ich sollte und wollte studieren. Die Wahl fiel auf Mathematik, obwohl ich dieses Fach im Vorabitur aufgegeben hatte, zugunsten Buchführung und BWL. Aber Mathematik hatte eine Schönheit und Eleganz, die ich in der kaufmännischen Welt nicht finden konnte.

Vielleicht weil mein Vater 2 Semester an der Technischen Hochschule in Berlin studiert hatte (1937/1938) und das ein sehr gutes Jahr in seinem Leben war (über das er gerne berichtete, ganz im Gegensatz zu seinen folgenden Jahren im WWII), hatte ich mir in den Kopf gesetzt, an einer Technischen Hochschule zu studieren. Da war für mich aber nur die TH in München erreichbar.

Wie ich mich einschreiben wollte, lernte ich, dass man Mathematik dort nur gemeinsam mit einem Nebenfach studieren konnte. Im Angebot waren BWL, Physik und das ganz neue Fach Informatik. Die ersten beiden Fächer mochte ich nicht. Wie ich dann entdeckte, dass Informatik mit den Themen der von mir geliebten „Science Fiction“-Literatur zusammen hing, war die Entscheidung einfach.

Algorithmen waren mir nur von der Modelleisenbahn bekannt. Von Computern wußte ich damals noch nichts. Ich weiß nicht, wie ich geantwortet hätte, wenn ich damals nach einem Unternehmen gefragt worden wäre, das Computer baut? Kann sein, dass ich IBM kannte. IBM ist die Abkürzung für „International Business Machines Corporation“. Sonst wußte ich sicher keinen Hersteller von Computern, wie ich auch keine Ahnung von „Geschäftsmaschinen“ hatte oder was man mit Computern eigentlich machen konnte. 1969 war die Götterdämmerung der Rechenschieber – und meiner war von Faber-Castell.

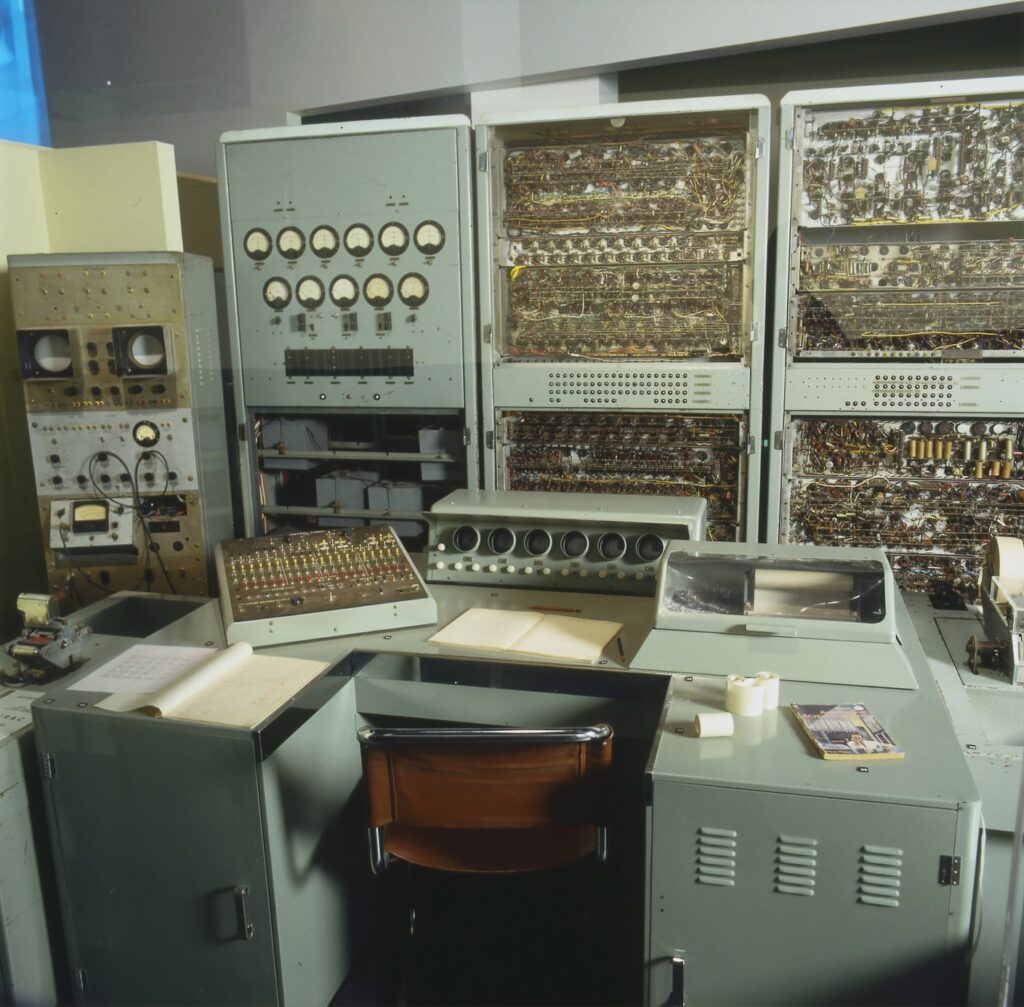

In meinem ersten Semester als Informatikstudent hatte ich nicht viel Kontakt mit Computern. Es gab ein wenig Berührung mit der PERM, einem kleinen Rechnermonster, das an der TUM entwickelt wurde. PERM ist die Abkürzung „Die Programmgesteuerte Elektronische Rechenanlage München“, sie war ein Röhrenrechner, der von Beginn der 1950er Jahre an der TH München (später umbenannt in TU München) entwickelt wurde. Sie erfüllte ihren Dienst bis ins Jahr 1974, da war sie dann schon ziemlich langweilig und wurde abgeschaltet (schlafen gelegt).

Als höhere Programmiersprache wurde uns ALGOL 60 und später 68 gelehrt. Eine Sprache, die ich dann praktisch nie so richtig genutzt habe.

Mein nächster und für mich sehr wichtiger Karriere-Schritt führte zur Siemens AG. Zuerst als Werkstudent, nach meinem Abschluss als festangestellter Mitarbeiter. Dort war ich im Paradies für Informatiker. Es gab so viel Rechner und Systemklassen, dass man gar nicht alle kennen lernen konnte.

Begonnen habe ich mit Prozessrechnern. Die Serie hieß 300, die Modelle hatte den klangvollen Namen 303, 304 und 306. Die 306 war der Superstar, mit diesem System konnten wir ein komplexes Prüfmuster für den Test von Flachbaugruppen an einem Wochenende generieren. Wir mussten nur rechtzeitig Freitag Abend starten – und es gab dann eine Chance, dass wir das Ergebnis am Montag früh hatte. Wenn nicht, dann mussten wir es eine Woche später wieder probieren, denn werktags wurde die wertvolle Hardware für andere Zwecke gebraucht.

Ich erinnere mich noch, dass der Assembler den schönen Namen PROSA hatte. Die Maschine hatte zwei Akkumulatoren (ein anderes Wort für Register), der Assembler hatte 6 Bit-Worte (das Halbwort 3 Bit). Es waren also Oktalrechner (0 -7). Bei den 300ern ging es um Geschwindigkeit, das Besondere der Hardware war die jederzeit mögliche Unterbrechbarkeit, ein notwendiges Feature eines Prozeßrechners.

Da das Betriebssystem der 300-Maschinen selber auf richtigen Rechnern „cross“entwickelt wurden, hatte ich vom ersten Tag an Zugang zu echten Mainframes. Siemens hatte damals zwei Betriebssysteme. Das BS1000 war ein einfaches auf einer Platte basierendes Runtime-System mit einem Overlay-Mechanismus – das vor allem als Teilhabersystem für Anwendungen genutzt wurde. Das andere hieß BS2000 und war ein ganz modernes Teil, wahrscheinlich das führende Betriebssystem seiner Zeit. Damit war ich schon der Welt weit voraus.

Siemens hatte es von RCA gekauft, die sich aus dem IT-Geschäft zurück zogen. Weil RCA nicht an die Zukunft von Großrechnern glaubet und den großen Computern nur schlechte Umsatzprognosen gaben. Wer brauche so etwas schon?

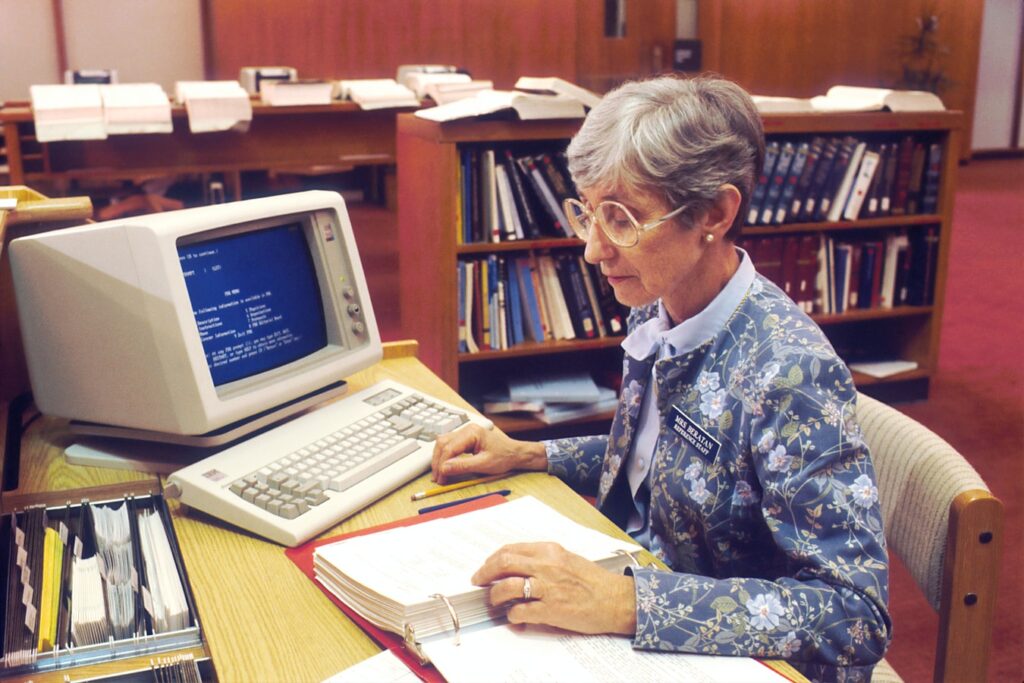

Die meisten Rechner in dieser Zeit (auch BS1000 und BS2000) verrichteten RJE-Dienste (Remote Job Entry). D.h sie haben lange Lochkartenstapel gefressen und Papier ausgedruckt. Ein Teilnehmerbetrieb mit Online-Änderungen, die auch gleich die Daten aktualisierten (Transaktionen) war damals die große Ausnahme. In der Regel wurden die Änderungen nur erfasst und über Nacht dann in Datenbasis eingespielt.

Das BS 2000 war nicht nur wegen seines Namens modern, nein es war das erste System im professionellen Einsatz, das einen virtuellen Speicher hatte. Die gerade nicht genutzten Seiten wurden ausgelagert und bei Bedarf wieder geladen. So konnte BS 2000 einen (virtuellen) Arbeitsspeicher von bis dahin ungeahnter Größe nutzen.

Die Informatik sprach vom „paging“, Siemens nannte das BS2000 ein Kachel-Betriebssystem. Das kann man im Siemens Lexikon der Datenverarbeitung wie auch in Professor Segmüllers Buch zu seiner Vorlesung „Betriebssysteme“ nachlesen. Wobei die Deutschen alles taten, um eine Anglisierung zu vermeiden. Wie übrigens auch die Franzosen, bei denen der Computer dann l’ordinateur hieß.

Siemens hatte auch noch Amboss-Rechner (die Nummer weiß ich nicht mehr) und Bürosysteme, in den folgenden Jahren wurden dann auch die freien einstelligen Ziffern mit den Typen für OEM-System wie Großrechner aus Japan mit den 7-Nummern und dem Betriebssystem BS3000 und Arbeitsplatzsysteme (OEM auf Basis des Xerox STAR-Systems als 6er. Das war dann die Spitzenklasse – und die Zukunft, an die wir glaubten.

Ich habe dann noch ein paar Jahre bei Siemens mit der Entwicklung von Transdata zugebracht. Aus dieser Zeit ist der hier abgebildete Rechner. Der Rechner ist einer der letzten Generation (Dup–MP), näheres dazu siehe weiter unten.

Die Rechner hatten die Ordnungsnummer 9xxx und wurden als Vorrechner, Netzknotenrechner oder Datenstationsrechner eingesetzt. Ihr Betriebssystem wurde für den Einsatzfall generiert, dazu gab es KOGS (konfigurationsorientierte Generatorsprache), mit der wir ein PDN (Programm zur Datensteuerung im Netzwerk) generierten. Ja, im Erfinden von Abkürzungen waren wir wirklich gut.

Mein Thema in Transdata war APS (Anwender Programmiersprache), mit der man in den Netzknotenrechern lokale Intelligenz realisierte. So wurde z.B. bei den Bankanwendungen der Geschäftsfall ‚SparmitBuch‘ komplett im Netzknotenrechner abgewickelt – und erst am wenn die Daten komplett gesammelt und geprüft waren, der Geschäftsfall an das BS2000 gesendet (über BCAM (basic communication access methode), DCAM ((basic communication access methode) an UTM/UDBS (Universaler Transaktionsmonitor und Universales Datenbanksystem), hinter denen sich die Anwendung im BS2000 befand.

Mein besonderes Thema war das ‚Connection Handling‘, das die physikalische und logische Kommunikation zwischen den physischen und logischen Stationen eines Transdata Rechnernetzes regelte. Für das Connection Handling war ich schon als Anfänger verantwortlich – und mächtig stolz drauf. Die Konkurrenz zu Transdate war SNA (System Network Architecture) von IBM. Weltweit gab es nichts vergleichbares.

Eine meiner Spezialitäten war später die Vernetzung von SNA- und Transdata-Systemen, unter anderem habe ich an einem Gateway mit entwickelt, der SNATCH (SNA-Transdata Coupling of Hosts) genannt wurde und Siemens-Netze mit IBM SNA verband.

Dann kamen die Microprozessoren. Und plötzlich wurde die Hardware nicht mehr eigenständig entwickelt, sondern auf Mikroprozessoren emuliert. Und war so viel schneller vorher. So wurde aus dem proprietären Datenübertragungsprozessor von Siemens ein Programm, dass diesen emulierte und auf einem Mikroprozessor lief. So hießt die gute alte ‚Duet‘ (diese Abkürzung weiß ich nicht mehr) plötzlich Dup-MP. Und das Betriebssystem PDN lief eins zu eins auf dem Dup-MP.

Die Rechner waren nicht nur schneller, sie wurden auch kleiner und leichter. Das war unfaßbar, viele Kollegen zweifelten, dass dies der richtige Weg sei. Alte deutsche Hardware durch amerikanische Microprozessoren zu ersetzen?

Aber verlassen wir die deutsche, damals schon ein wenig spießige Welt. Die Musik hat damals in USA gespielt. IBM immer ganz klar der Marktführer. Weiter tauchten in den folgenden Jahren viele andere Unternehmen und ihre Systeme aus den USA bei mir auf.

IBM war eine Klasse für sich. Sie hatten reife Produkte mi tollen Manualen. Die waren für uns bei Siemens Vorbilder. Aber IBM kam mir nicht so innovativ vor, da haben mich DEC, HP und SUN am meisten beeindruckt.

Ich war ein Spezialist der Siemens-Technologie. Und wollte immer IBM-Technologie (BIG BLUE) kennen lernen. Das war auch ein Grund, warum ich bei Siemens gekündigt habe (neben monetären Gründen). Und kaum hatte ich ein wenig IBM gelernt (begonnen mit SNA, Abkürzung für System Network Architecture – die Konkurrenz zu Transdata), kamen ganz viele neue Firmen in meine Welt. Die hießen DEC, HP, Apollo, Sun … Und da sah BIG BLUE auch bald wieder ein wenig alt aus.

DEC war für mich das Computerunternehmen der „mittleren Datentechnik“. Mit Vax und PDP11 hatten sie moderne Rechner und mit VMS ein wunderbares Betriebssystem. Für mich waren sie der Internet-Pionier.

So kann ich mich gut erinneren, wie ich in einem Zelt bei einer DEC-Roadshow das erste Mal mit dem großen WWW (world wide web) spielen durfte. Die Abkürzung www wurde bei uns dann zu „wait, wait, wait“.

Hewlett Packard. kam von Messinstrumenten und Taschenrechnern. Das Unternehmen war der Hersteller von Workstations. Besonders nachdem sie Apollo übernommen hatten. Apollo waren Entwicklungsrecher. Sie wurden bei der Übernahme zerlegt. Der Hardwareteil kam zu HP, die Software wurde weitergeführt.

https://de.wikipedia.org/wiki/Rational_ClearCase https://de.wikipedia.org/wiki/Apollo_Computer

DEC verlor nach meiner Meinung, weil sie sich nie strategisch zu Unix bekannten. So wurden sie vom PC-Hersteller Compac geschluckt. HP stellte die Weichen für alles seine Systeme auf Unix (bis auf ein paar PCs und Laptops. Und schluckte dann DEC-Schlucker compaq.

SUN war sensationell. Ich dachte immer, dass der Firmenname mit der Sonne zu tun hatte. Denkste. Später lernte ich, dass sun ganz schlicht die Abkürzung für „stanford university network“. Das Unternehmen wurde von der Uni gegründet, um das IT-Netz der Hochschule aufzubauen. Und weil ein Netz auch Workstations brauchte haben sie auch gleich Workstations und Server.

Ich kann mich an meine Besuche bei den Technologie Evangelisten der SUN erinnern. Die immer wieder das Prinzip „The network ist the computer“ belegten. Und mit Java brillierten. Und wunderbare Software aller Art vorführten.

Aber auch SUN war nicht von Bestand. Kaum hatten sie mysql geschluckt, wurden sie von Oracle übernommen. Oracle wollte die mächtige IT-Firma werden, die Hardware und Software aus einer Hand liefern konnte. Hat wohl auch nicht so geklappt.

In Deutschland hatten wir auch Unternehmen, die solche Sachen bauen sollten. Am meisten Kontakt hatte ich mit PCS (Periphere Computer Systeme). Die sassen unweit vom Giesinger Bahnhof und bauten Workstation und Server. Sie hießen CADMUS und Mehrplatzsyseme. Auch gab es ein Unternehmen Kontron, die kleine Unix-Rechner baute.

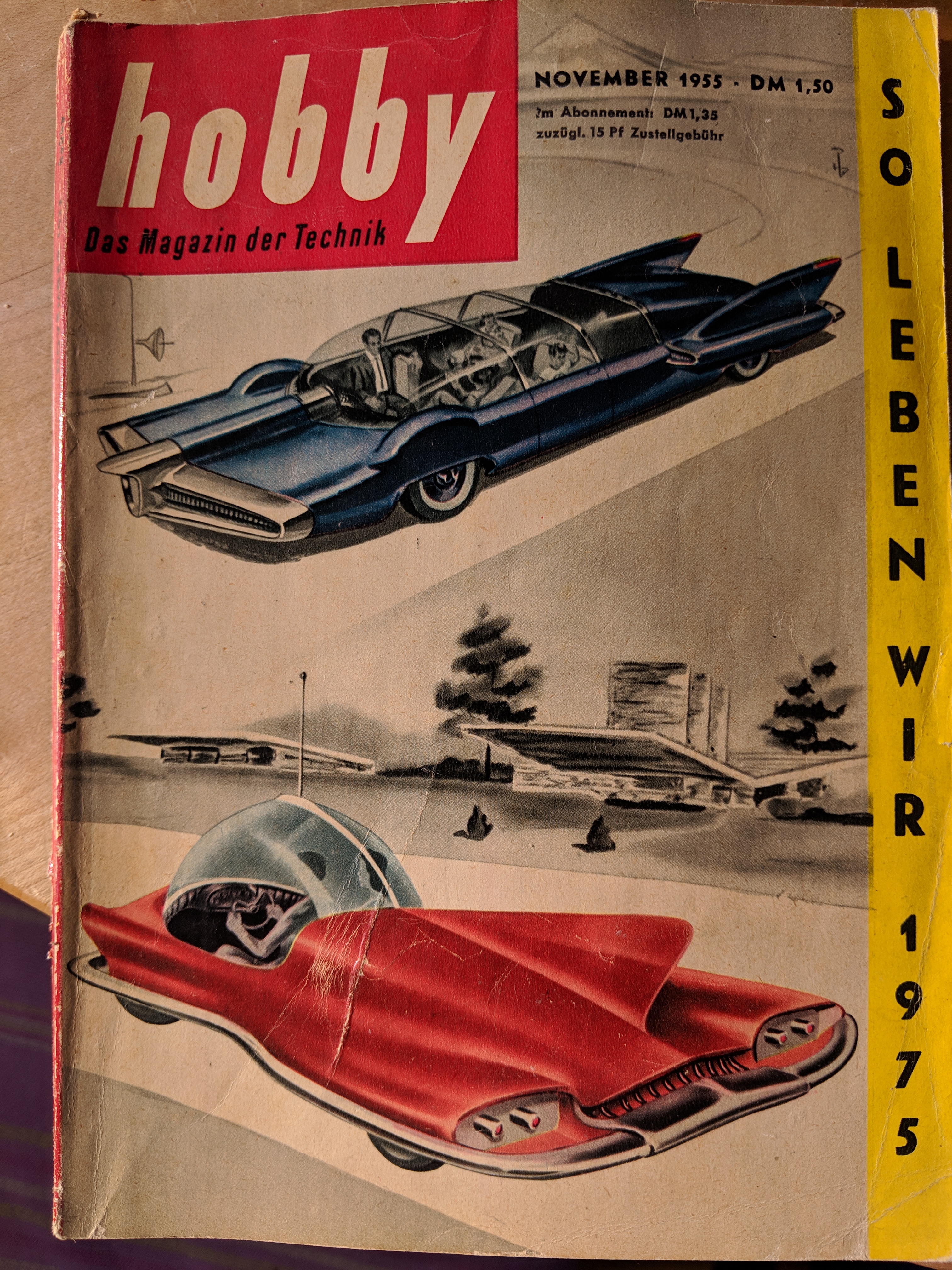

Auf einer Kontron habe ich 1983 das „Pflichtenheft“ (es war eher ein visionäres Dokument) für HIT geschrieben. Ich erinnere mich damals, das Kontron früh Teil des BMW-Konzerns wurde. Weil die BMW damals annahm, dass das Auto keine rechte Zukunft haben dürfte – und sie ein wenig in Zukunftstechnologie investieren wollten. Es gab auch die Uhren- und Taxometer-Firma Kienzle, Schreibmaschinen-Firmen wie Triumph-Adler, die alle ein Stück vom neuen IT-Kuchen abhaben wollten.

Beschränkt ist das ihnen auch gelungen. Aber so richtig im Server-Markt konnten sie mit Ihren gar nicht mal schlechten aber einfach nicht konkurrenzfähigen Produkten nie landen.

Parallel ging das Licht von Intel und Konsorten auf. Immer wieder schienenandere Unternehmen im Markt derMicroprozessor die Führung zu zu übernehmen. Ich erinnere mich wie kurzfristig Zilog und später die diversen RISC-Prozessoren (Reduced Instruction Set Computer) von National Semiconductor, Motorola oder Mips und Advanced RISC Machines (ARM) die Führung übernahmen. Letzten Ende hat sich wohl Intel durchgesetzt und sein „look alike“ AMD oder der chinesische Konzern Zhaoxin. Jetzt sind wir aber schon in der Gegenwart, da höre ich dann auf.

In Europa passierte nicht viel. Alle Europäischen IT-Firmen kämpften um ihre Existenz. In England waren es die ICL, in Frankreich Bull, in Italien Olivetti, in Deutschland Siemens und Nixdorf (zwei verfeindete Brüder) und viele kleine Unternehmen, wie Kienzle, Telenorma oder CGK (Computer Gesellschaft Deutschland). Siemens waren die größten, sie hatten alles. Für alle möglichen Zwecke spezialisierte Rechner, Platten, Drucker, Endgeräte, Kommunikationstechnologie und große Werkbänke für SW- und HW-Entwicklung. Siemens war technologisch eine Macht, aber leider wirtschaftlich und vertrieblich mit seinen Produkten der Datenverbeitung nicht so erfolgreich wir im restlichen Konzern (Siemens machte alles, was mit Strom zu tun hatte.

Immerhin hatte Siemens als erstes Unternehmen verstanden, dass Software einen großen Wert hat und das „Unboundle“ (getrennte Bepreisung von Hardwarw und Software eingeführt. Technologisch war Siemens bei vielen Themen gut dabei. Deutsche Planungswut und der mangelnde Mut zur ingenieurmäßigen Agilität hat das Knowhow vertrieben und das Unternehmen ruiniert. Und damit wahrscheinlich die Europäische IT.

Nixdorf war vor allem in der MDT (mittleren Datentechnik) erfolgreich. Der Fehler war, dass sie Geld nur für die Hardware verkauften, aber die Software her geschenkt haben. Die anderen deutschen Computer-Unternehmen (Kienzle, Adler, CGK, TA) kamen bei uns wie die europäischen Konkurrenten nie so recht an den Markt.

Es gab einen interessanten Versuch in Europa, den ich selbst noch miterlebt habe. Wohl nach dem Vorbild der Luftindustrie sollte es einen starken europäischen IT-Konzern geben. Er nannte sich CII (Compagnie Internations Informatique). Die Gründungsmitglieder waren Siemens, ICL und Bull, der Name französich und die Geschäftssprache englisch. Ich erinnere mich, dass wir damals von heute auf morgen alle Protokolle auf englisch schreiben mussten.

Aber die Staatsgelder blieben wohl aus und nach einem dreiviertel Jahr war der Spuk vorbei. Später fusionierten Siemens und Nixdorf zur SNI (Siemens Nixdorf IT) Im und das Leiden verschlimmerte sich.

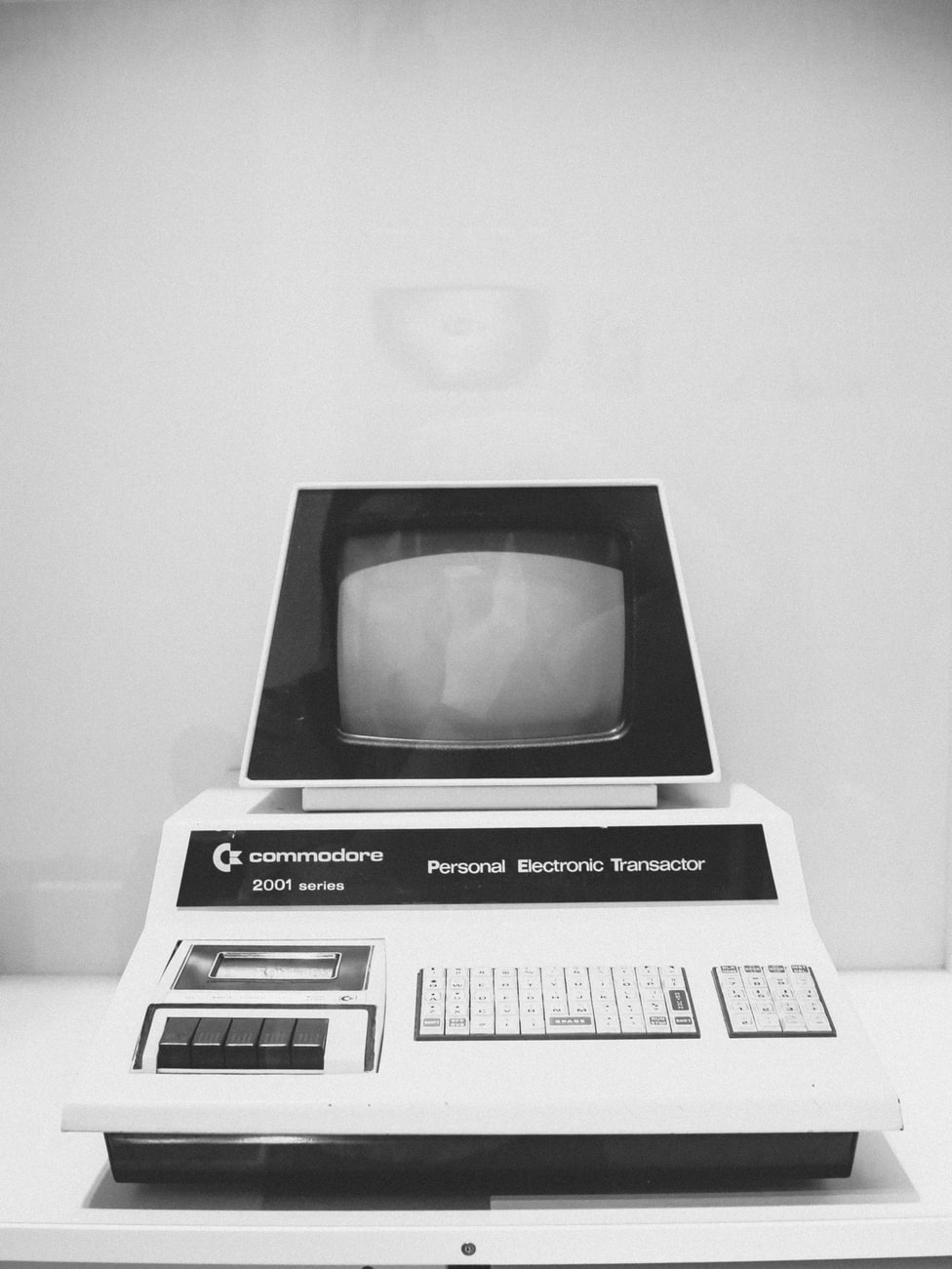

In dieser Zeit kamen auch die ersten Heimcomputer auf dem Markt. Die waren für den privaten Benutzer sündhaft teuer – in Verhältnis zu den Preisen der Mainframes allerdings spottbillig. Ich las von den Ataris und Commodores und verfolgte das Thema aber nur so nebenher. Allerdings erlosch mein Interesse schnell, kam ich doch aus der „Industrie-Informatik“. Und da waren diese Heimcomputer eher lächerlich.

Zum Speichern der Daten und Programme nutzen sie einen einfachen Cassettenrecorder, als Bildschirm diente ein flimmender Farbfernseher. Da war ich anderes gewohnt, die Zeit für solche Spielzeuge hatte ich auch nicht. Jahre später habe ich verstanden, dass ich mehr um diese wunderbare alternative Technik hätte kümmern sollen. Vielleicht hätte ich dann besser verstanden wo die IT hin geht und meinerseits weniger strategische Management-Fehler gemacht.

Zum Speichern der Daten und Programme nutzen sie einen einfachen Cassettenrecorder, als Bildschirm diente ein flimmender Farbfernseher. Da war ich anderes gewohnt, die Zeit für solche Spielzeuge hatte ich auch nicht. Jahre später habe ich verstanden, dass ich mehr um diese wunderbare alternative Technik hätte kümmern sollen. Vielleicht hätte ich dann besser verstanden wo die IT hin geht und meinerseits weniger strategische Management-Fehler gemacht.

Jetzt hätte ich fast einen Exoten vergessen, auf dem ich viel gearbeitet und den ich richtig geliebt habe. Das war das System Pet-Maestro (lesenswerter Artikel in Wikipedai) von Softlab, das auf Philips-Hardware basierte. Es war ein auf Software-Entwicklung von Cobol-Programmen spezialisiertes System.

Ich habe es so geliebt, weil es das erste System war, auf dem ich keine Daten mehr verloren habe, denn die Hardware sicherte zeichenweise. So konnte ich beim Rechnerabsturz, den es damals auf allen Systemen häufig gab, immer da weiterarbeiten, wo es geendet hatte. Und mußte nicht die Arbeit – manchmal von Stunden – nochmal machen

Und das Pet-Maestor hatte ein Kameraprinzip – das bedeutete, dass es Bildschirm nicht in Fenster zerlegte (ging damals bei zeichenorientierten Bildschirmen eh nicht sinnvoll) sondern durch Virtualisierung die Möglichkeit anbot, mehrere Bildschirme parallel zu nutzen (ähnlich wie die Spaces beim Mac).

Die Ansteuerung der Bildschirme ging über den Ziffernblock rechts auf der Tastatur, so konnte man elegant auch Daten von einem Bildschirm in den anderen kopieren. Und das Prinzip von Harald Wieler ging voll auf. Er wollte den eh zu kleinen Bildschirm nicht in Fenster zerlegen, sondern vervielfachen. Ein genial einfaches Prinzip, das des Programmierers Glück auch vervielfältigte. Das habe ich Ende 1970 erlebt.

PetMaestro I war sehr erfolgreich. Anfang der achtziger Jahre wurde die Philips-Hardware nicht mehr hergestellt, es gab Schwierigkeiten bei den Ersatzteilen. So entschloss sich Softlab im Jahre 1989 zu einer völligen Neuimplementierung Maestro II als Client-Server-Agentur. Auch ein sehr lesenswerter Artikel in Wikipedia. Leider war es zu spät, und die tolle Client-Server-Lösung von Softlab floppte am Markt. Weil es einfach zu spät kam und die „jungen Wilden“ aus USA schon gesiegt hatten.

Die lange vergangene Zeit, die ich hier beschreibe, war noch die Zeit der weißen und grauen bzw. Mäntel. Das war so. Der gemeine IT-Mitarbeiter ging natürlich mit Anzug und Krawatte ins Büro. Die lockeren zogen ein Sacco an – aber auch das ging nur mit Schlips. Rolli oder so etwas hatte nur Steve Jobs und die Amis an.

Im Büro angekommen, wurde das die Anzugs-Jacke ausgezogen und ein Labormantel angezogen. Die Programmierer hatten weiße Mäntel, die Mäntel der Operateure und Konstrukteure waren blau oder grau. Ich habe mich sofort für den weißen Mantel entschieden und wurde Programmierer.

Weiter Große Namen der Branche

Große Namen waren auch Yahoo, AOL …, die neben den großen wichtig waren. Dann kam die Welt von Microsoft, Oracle, Dell, Google und noch später Twitter und Facebook. Die Männer der Stunde waren Bill Gates, Larry Ellison, Michael Dell, Larry Page, Sergey Brin, Biz Stone, Jack Dorsey, Mark Zuckerberg.

Und über die Server- und Storagefarmen (EMC und NetApp) ging es hinein in die Clouds von Amazon (AWS), Microsoft (Azure) und natürlich Google.

Wir dürfen die großen digitalen Unternehmen, die die Rolle der Großväter hatten, nicht vergessen, wie Xerox und erstaunlicherweise Kodak!. Xerox hatte den Star – über Siemens auch an die Lufthansa verkauft, das erste Wysiwyg-Bürosystem, den Urahn von Mac und Lisa.

Kodak hatte früh erkannt, dass die anloge Fotografie verschwinden wird, und alle Patente für die digitale Fotografie. Nur haben sie das viel zu früh erkannt. Und erst als die Kodak’schen Patente ausliefen ging das digitale Rennen los. Das alte Problem: Die ersten Pioniere wartet der Tod, auf die nächste Generation die Not und auf die späteren dann das Brot.

Und HP als der Druckerchampion wollte mit seiner legendäre „Wind-of-Change“-Strategie dass Rennen der digitalen Fotografie gewinnen – und scheiterte schon beim Start. Die digitale Fotografie zeigt – wie auch übrigens auch die 3D-Drucker-Geschichte – dass heute Patente die Technologie nicht mehr befördern sondern behindern. Aber die heilige Kuh des Eigentums ist das moderne „goldenes Kalb“, besonders wenn es um Daten und Urheberrechte geht.

Wir waren so froh, wenn der Start des Rechners glückte

Aber in diesen Jahren am Anfang der IT war es ein Riesenjob, einen Rechner zum Laufen zu bringen und dann am Laufen zu halten. Überall lauerten Fallen. Und wenn das System dann mal ein paar Stunden am Stück lief, war das ein großer Glück.

Ich erinnere mich, wie ich viele Stunden im Feurich-Bau (einer ehemaligen Keksfabrik, die von Siemens in den Standort integriert wurde und in der wir unsere neue Hardware testeten) in der Hofmann-Straße mit Endgeräten und diverser Technologie gekämpft haben. Mal wollte der Lochstreifenstanzer oder Lochkartenleser nicht so wie ich. Oder der Rechner verlor sein Kühlwasser oder wurde aus anderen Gründen zu warm. Und dass wieder mal ein paar Speicherzellen defekt waren, war trister Alltag.

Und ich bin weit nach Mitternacht frustriert heimgeschlichen. Und musste warten, bis die Fehler dann wieder repariert waren. Das war alles andere als #devops.

RMD

P.S.

Jetzt habe ich ganz vergessen, auf die Urgesteine hinzuweisen, wie RCA oder Univac. Über diese Dinosaurier der IT gibt es mehr in meinem Artikel IT-Geschichte ab 1950.

Viel Lektüre für IT-Hobbyisten, die Vintage mögen, findet sich hier (http://bitsavers.trailing-edge.com/pdf/computersAndAutomation/).

Die Sammlung beginnt mit

Vol. 3, No. 9 – Nov. 1954 von

COMPUTERS and AUTOMATION

(CYBERNETICS • ROBOTS • AUTOMATIC CONTROL)

http://bitsavers.trailing-edge.com/pdf/computersAndAutomation/195411.pdf

bis zu

Vol. 27, No.3 – March, 1978

computer’s … and people

(formerly Computers and Automation)

Zum Beispiel in

In Vol. 4 No.3 – March 1955

eine wunderbare Anzeige von UNVAC und

eine Geschichte „QUESTION“ von Isaac Asimov

http://bitsavers.trailing-edge.com/pdf/computersAndAutomation/195503.pdf

Das ganze ist eine wahre Fundgrube!